기타

copilot 무료로 사용하기

알면 알 수록 재밌다!

2024. 6. 16. 09:01

로컬 환경에서 LLM을 설치하고 vscode와 연동해 copilot 처럼 사용하는 방법입니다.

https://www.ollama.com/download

Download Ollama on macOS

Download Ollama on macOS

www.ollama.com

해당 사이트에 접속해서 ollama를 설치해주세요.

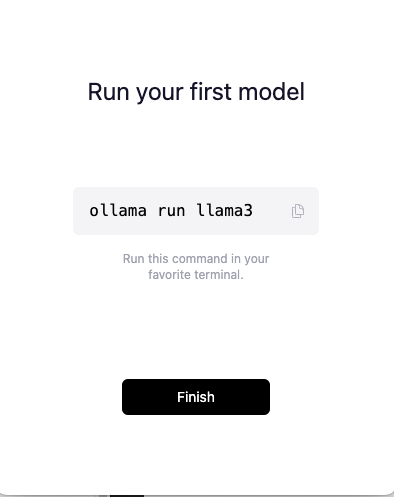

다 설치되면 위처럼 모델을 설치하라고 합니다.

https://github.com/ollama/ollama

GitHub - ollama/ollama: Get up and running with Llama 3, Mistral, Gemma, and other large language models.

Get up and running with Llama 3, Mistral, Gemma, and other large language models. - ollama/ollama

github.com

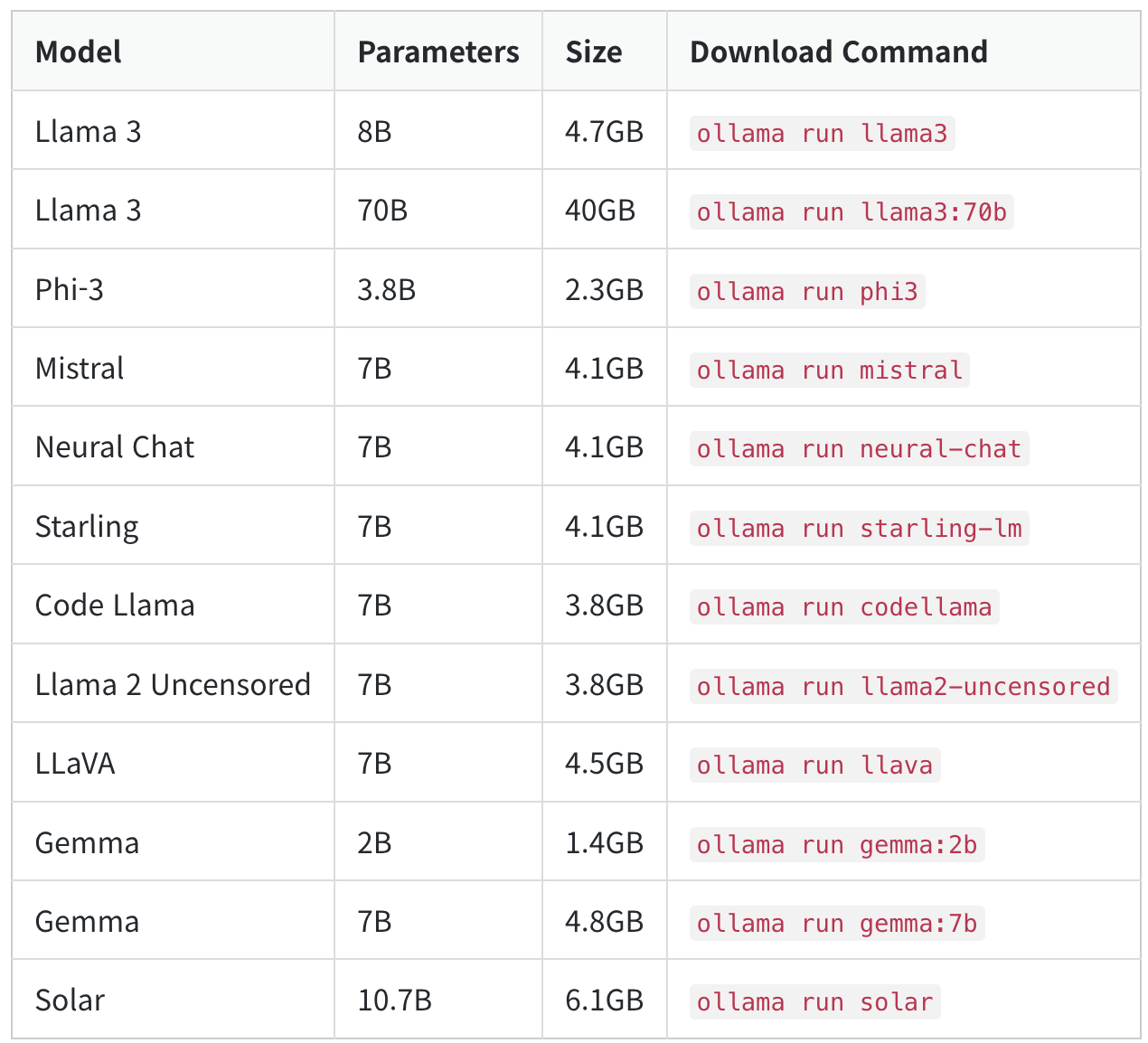

모델은 여러개가 있으니 확인하시면 됩니다.

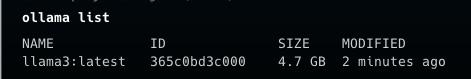

위처럼 설치되어있는 LLM 모델을 확인할 수 있습니다.

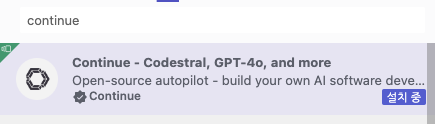

해당 extension을 설치하고

ollama run starcoder2:3b

위 모델을 설치해야합니다.

그러면 copilot처럼 사용 가능합니다.

참고로 기존에 copilot을 사용중이었다면 해당 extension을 disable해야합니다.

참고

https://www.youtube.com/watch?v=e9-z1GqG2_c